Google – это не только самый популярный поисковик, но и одна из крупнейших компаний в мире, которая каждый день улучшает свои алгоритмы поиска. С самого запуска в 1998 году Google придерживается принципа предоставления пользователям наиболее релевантной информации для их запросов.

Основой работы Google являются алгоритмы, которые определяют ранжирование страниц в поисковой выдаче. С течением времени Google внесли множество изменений в свои алгоритмы, чтобы бороться с спамом, обеспечивать высокое качество поискового опыта и предоставлять наиболее полезные результаты.

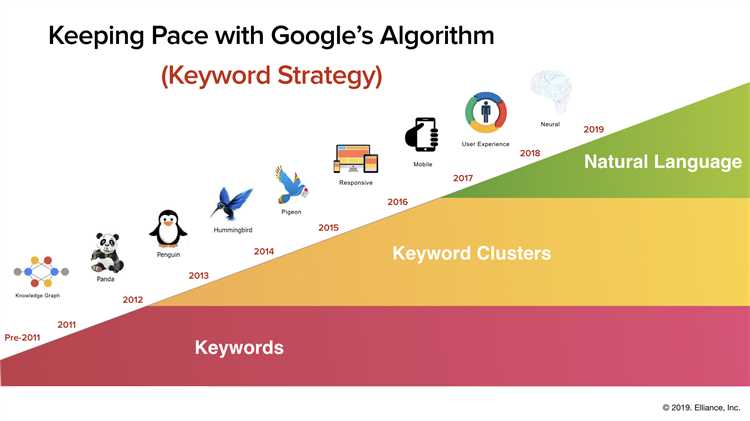

Наша инфографика представляет собой историю изменений алгоритмов Google с 1998 по настоящее время. Она поможет вам понять, какие периоды в истории Google были особенно важными, и какие алгоритмы были запущены в эти периоды.

История изменений алгоритмов Google (Инфографика)

Инфографика наглядно показывает, как Google постоянно совершенствует свои алгоритмы для обеспечения более точных и полезных результатов поиска. В процессе своего развития Google внедрял новые факторы ранжирования, такие как качество контента, ссылочная масса, пользовательская опыт и многие другие. Такие важные обновления, как Panda, Penguin и Hummingbird, сделали поиск более адаптивным и улучшили пользовательский опыт.

Важные изменения алгоритмов Google:

- Panda (Февраль 2011): алгоритм, направленный на борьбу с низкокачественным и дублирующимся контентом.

- Penguin (Апрель 2012): алгоритм, который наказывает сайты за использование некачественных и спамовых ссылок.

- Hummingbird (Август 2013): обновление алгоритма, которое сделало поиск более семантичным и улучшило понимание запросов пользователей.

- Mobile-Friendly (Апрель 2015): алгоритм, который ранжирует мобильные сайты выше в поисковой выдаче для мобильных пользователей.

- RankBrain (Октябрь 2015): алгоритм, использующий искусственный интеллект для анализа и понимания запросов пользователей.

Инфографика позволяет легко увидеть историческую эволюцию алгоритмов Google и их вклад в поисковую систему. Эти изменения были созданы для того, чтобы помочь пользователям получать более точные и релевантные результаты поиска.

Первые шаги: появление Google

Первая версия поисковой системы Google запустилась в 1998 году. Название «Google» происходит от английского словосочетания «googol», которое обозначает число 1 с 100 нулями. Это название символизировало огромное количество информации, которое Google собиралась обрабатывать и предоставлять пользователям.

С первых дней своего существования Google отличалась от других поисковых систем своей эффективностью и точностью выдачи результатов. Ее алгоритм был основан на учете ссылочной структуры интернета, то есть, учитывались ссылки, указывающие на определенную страницу. Такой подход сделал Google лучшей поисковой системой на рынке и привлек множество пользователей.

Google также была первой поисковой системой, которая предложила рекламодателям эффективную модель монетизации с помощью контекстной рекламы. Этот подход позволял показывать рекламу, соответствующую запросу пользователя, и делал поиск не навязчивым для пользователей, за счет отсутствия рекламного спама.

PageRank: первый важный алгоритм

PageRank был назван в честь Ларри Пейджа и стал одним из основных факторов, определяющих ранжирование страниц в поисковых результатах Google. Этот алгоритм стал ключевым прорывом в области поиска и позволил Google стать лидером в поисковой индустрии.

PageRank рассматривает каждую страницу как узел веб-графа и просчитывает ее значимость на основе количества входящих связей от других страниц и их веса. Вес каждой входящей ссылки увеличивается, если она исходит от страницы с высоким ранжированием. Таким образом, веб-страницы, на которые ссылается много других страниц с высоким ранжированием, получают более высокую оценку и, следовательно, высокие позиции в результатах поиска.

Весь алгоритм PageRank можно представить в виде графа, где каждая страница представлена узлом, а ссылки между страницами — ребрами. С помощью этого графа можно расчитывать PageRank каждой страницы и определить ее ранжирование в поисковой выдаче.

PageRank стал первым надежным способом оценки веб-страниц и до сих пор остается одним из важных факторов ранжирования в поиске Google. Впоследствии были разработаны и внедрены другие алгоритмы, учитывающие более широкий спектр факторов, но PageRank остается основой для определения значимости страниц.

Florida: первое большое изменение

В марте 2003 года Google выпускает свой первый крупный алгоритмический апдейт, получивший название «Florida». Это изменение алгоритма существенно повлияло на ранжирование сайтов и сильно потрясло сообщество SEO.

Перед апдейтом Florida, многие вебмастера и SEO-специалисты злоупотребляли техниками «поиск ключевых слов» и «нагнетания ссылочной массы». Эти приемы помогали сайтам занимать высокие позиции в результатах поиска, но игнорировали реальное качество контента.

С выходом алгоритма Florida все изменяется. Google начинает активно бороться с так называемым «спамом», а именно – с некачественным содержанием, неестественной ссылочной массой и манипуляциями с ключевыми словами. Алгоритм Florida значительно улучшает релевантность результатов поиска и нивелирует некоторые «черные» SEO-техники.

Для многих сайтов владельцы и SEO-специалисты падение позиций оказалось весьма шокирующим. В то же время, новый алгоритм позволил появиться на вершинах выдачи более полезным и качественным сайтам, что положительно сказалось на опыте пользователей. Florida стал первым шагом в развитии лучшего поисковика, где качество контента и удовлетворение запросов пользователей стали приоритетом.

Панда: борьба с низкокачественным контентом

Алгоритм Панда, запущенный Google в 2011 году, был разработан для борьбы с низкокачественным и поверхностным контентом на веб-сайтах. Он стал одним из самых влиятельных обновлений алгоритма поиска и значительно повлиял на ранжирование сайтов в результатах поиска. Панда введена для того, чтобы поднять качество контента и обеспечить более полезные результаты для пользователей.

Алгоритм Панда работает на основе более чем 20 различных сигналов, которые помогают определить качество контента и соответствие требованиям пользователей. Он анализирует такие факторы, как уникальность контента, его полезность, релевантность и авторитетность. Если сайт содержит низкокачественный или скопированный контент, нарушающий эти критерии, он может быть наказан в результатах поиска.

Как бороться с низкокачественным контентом:

- Создавать уникальный и полезный контент: Важно создавать оригинальный и информативный контент, который решает проблемы пользователей и предлагает им ценную информацию.

- Избегать скопированного контента: Необходимо избегать копирования контента с других сайтов или использования автоматического генерирования контента.

- Оптимизировать качество страниц сайта: Улучшайте качество страниц, убирая ненужный и поверхностный контент, исправляя опечатки и грамматические ошибки.

- Использовать авторитетные источники: Если вы используете цитаты или информацию из других источников, убедитесь в их авторитетности и предоставьте ссылки на них.

- Обратить внимание на показатели взаимодействия пользователей: Мониторьте показатели, такие как отказы, время проведенное на сайте и клики, чтобы определить, насколько пользователи довольны вашим контентом.

С учетом этих рекомендаций можно повысить качество контента на своем сайте и улучшить его позиции в результатах поиска Google. Это поможет привлечь больше органического трафика и улучшить пользовательский опыт.

Penguin: борьба с некачественными ссылками

Алгоритм Penguin, запущенный Google в апреле 2012 года, был разработан для борьбы с некачественными ссылками, которые использовались в SEO оптимизации сайтов. Этот алгоритм стал серьезным шагом в борьбе с недобросовестными практиками и позволил повысить качество поисковой выдачи.

Алгоритм Penguin анализирует ссылочный профиль сайта и оценивает его качество. Основной целью алгоритма является выявление и наказание сайтов, которые используют неестественные ссылки для получения лучшей позиции в поисковой выдаче. Такие ссылки могут включать в себя покупные ссылки, ссылки из низкокачественных каталогов, а также ссылки с других сайтов с низким авторитетом.

Алгоритм Penguin оценивает не только количество ссылок, но и их качество. Более того, алгоритм анализирует естественность ссылочного профиля — то есть, рассматривает, насколько органичными и естественными выглядят ссылки и их анкоры. Если ссылочный профиль сайта выглядит неестественным, то есть содержит слишком много некачественных ссылок, сайт может быть наказан снижением позиций в поисковой выдаче.

Для сайтов, получивших негативное влияние от алгоритма Penguin, востановление прежней позиции может быть длительным процессом. Владельцам таких сайтов рекомендуется удалить некачественные ссылки вручную и отправить запрос на рассмотрение в Google через Инструменты для веб-мастеров. Кроме того, необходимо активно работать над улучшением качества ссылочного профиля и использовать только естественные и качественные ссылки.

Hummingbird: фокус на смысле запросов

Алгоритм Hummingbird, запущенный Google в 2013 году, был значимым шагом в развитии поисковой системы. Основным улучшением этого алгоритма стало обращение к смыслу запросов пользователей, а не просто к набору ключевых слов. Это позволило улучшить релевантность поисковой выдачи и предложить пользователям более точные и полезные результаты.

Hummingbird принес ряд изменений, направленных на улучшение понимания контекста запросов и намерений пользователей. Алгоритм начал более глубоко анализировать семантическую связь слов и фраз, а также использовать понимание смысла слова в зависимости от контекста предложения.

В результате этого обновления, Google стал лучше понимать длинные и сложные запросы, включая вопросительные предложения и фразы с пропущенными словами. Теперь поисковая система может более точно интерпретировать пользовательские запросы и сникнуть результаты, соответствующие их намерениям.

В целом, Hummingbird улучшил опыт пользователей, обеспечивая более релевантные и точные результаты поиска. Запросы теперь понимаются как целые предложения, а SEO-специалистам стало важнее обращать внимание на семантические связи и контекст запросов при оптимизации контента для поисковой выдачи.