JavaScript — это один из самых популярных языков программирования, который широко используется для создания интерактивных веб-сайтов. Хотя JavaScript делает сайты более динамичными и удобными для пользователя, поисковые роботы, включая «Яндекс», не всегда хорошо индексируют сайты, построенные на JavaScript. В связи с этим, владельцам веб-сайтов необходимо применять определенные методы, чтобы сделать свой сайт на JavaScript более удобным для поисковых систем.

Одним из способов подружить поискового робота «Яндекса» с сайтом на JavaScript является использование техники «прогрессивного улучшения». Эта техника предполагает создание веб-сайта, который будет работать независимо от наличия JavaScript, но при этом предоставлять дополнительные функции и улучшения для пользователей, которые используют JavaScript. Таким образом, даже если поисковый робот не может полностью проиндексировать JavaScript-функциональность сайта, пользователи все равно смогут получить весь необходимый контент.

Другим способом улучшить индексацию сайта на JavaScript является использование техники «отложенной подгрузки контента». Вместо загрузки всего содержимого сразу, при этом фактически задерживая загрузку, можно предоставить минимальное содержимое «передочной страницы», доступное для поисковых роботов. Затем с помощью JavaScript можно загрузить остальной контент после того, как страница отображена для пользователя. Это позволит поисковым роботам получить основную информацию о контенте страницы, улучшая ее индексацию.

Как подружить поискового робота «Яндекса» с сайтом на JavaScript

При создании сайта на JavaScript важно помнить, что поисковые роботы не могут обрабатывать клиентские скрипты. Работа поисковых систем основана на анализе HTML-кода страницы, поэтому необходимо предоставить такую версию сайта, которую поисковых роботы смогут корректно просканировать и проиндексировать.

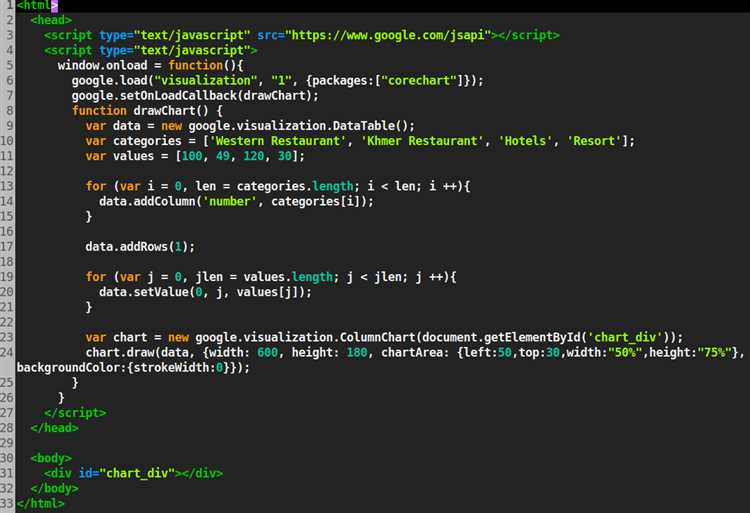

Для того чтобы подружить поискового робота «Яндекса» с сайтом на JavaScript, можно использовать несколько методов. Во-первых, необходимо обеспечить грамотную структуризацию содержимого вашего сайта. Разделите его на блоки и используйте соответствующие теги для их отметки: h1, h2, h3 для заголовков, p для абзацев, ul, ol, li для списка и table для таблиц.

- Используйте заголовки разного уровня для иерархической организации информации.

- Внутри абзацев выделяйте ключевые слова и фразы с помощью тега .

- Пользуйтесь списками для удобного представления структурированной информации.

- Используйте таблицы для отображения табличных данных.

Зачем это нужно?

Основной инструмент для этого — оптимизация сайта с учетом требований поисковых алгоритмов «Яндекса». Понимание работы поискового робота и умение оптимизировать сайт под него — это основа успешного продвижения в поисковых системах и увеличения органической посещаемости.

Оптимизация сайта для поисковых систем помогает улучшить его видимость в результатах поиска и увеличить естественный трафик. Чем лучше структурирован и оптимизирован сайт, тем больше вероятность привлечь качественных пользователей, которые заинтересованы в тематике сайта и готовы совершить целевое действие — покупку товара, оформление подписки и т.д. Благодаря оптимизации для поисковых систем, можно увеличить конверсию сайта и улучшить его метрики, такие как отказы и средняя продолжительность сессии.

Понимание работы поисковых роботов

Поисковые роботы, такие как роботы Яндекса, Google и других поисковых систем, играют важную роль в поисковой оптимизации (SEO) и процессе индексации веб-сайтов. Эти роботы автоматически сканируют, индексируют и классифицируют содержимое веб-страниц, чтобы предоставить наиболее релевантные результаты на поисковых страницах. Понимание того, как работает поисковый робот, поможет веб-разработчику оптимизировать сайт, чтобы он был легко обнаруживаемым и индексируемым для поисковых систем.

Работа поисковых роботов начинается с отправки запросов к веб-серверам и получения ответов в виде HTML-страницы. Робот анализирует содержимое страницы, сканирует ссылки и следует за ними, чтобы найти новые страницы для индексации. Роботы также обрабатывают мета-теги, заголовки и другие элементы HTML, чтобы понять тему и структуру веб-страницы.

Структура и организация информации на веб-странице имеют важное значение для поисковых роботов. Чтобы упростить индексацию и обнаружение важных страниц, разработчики должны использовать правильные HTML-теги, такие как заголовки h1, h2 и теги p для разделения контента. Ключевые слова и фразы должны быть выделены с помощью тегов или , чтобы поисковый робот мог лучше понять, что они являются важными для страницы.

- Сканирование и индексация

- Мета-теги и заголовки

- Использование правильных HTML-тегов

- Выделение ключевых слов и фраз

Изучение и понимание работы поисковых роботов поможет вам разработать оптимизированный сайт, который будет легко обнаруживаться и индексироваться поисковыми системами. Это в свою очередь повысит видимость и рейтинг вашего сайта, что может привести к увеличению трафика и посетителей.

- Улучшение видимости сайта

- Увеличение трафика и посетителей

- Рейтинг в поисковых системах

- Оптимизация контента и структуры сайта

В целом, понимание работы поисковых роботов является важным аспектом SEO и помогает веб-разработчикам создать сайт, который будет успешно оптимизирован для поисковых систем и отлично проиндексирован.

Основные проблемы между JavaScript и поисковыми роботами

Одной из основных проблем является то, что поисковые роботы не могут полностью интерпретировать и выполнить код JavaScript. Это значит, что если сайт полностью или частично зависит от JavaScript для отображения контента, поисковый робот может не видеть этот контент и не сможет его проиндексировать. Это может привести к тому, что страницы сайта не будут отображаться в поисковой выдаче.

Еще одной проблемой является время загрузки страницы, особенно при использовании большого количества скриптов и стилей JavaScript. Поисковые роботы стараются сканировать страницы быстро, и если сайт задерживает загрузку из-за сложного JavaScript, это может отрицательно повлиять на показатели SEO.

- Проблема 1: Неполная интерпретация и выполнение кода JavaScript поисковыми роботами.

- Проблема 2: Задержка загрузки страницы из-за сложного JavaScript.

Чтобы минимизировать эти проблемы, рекомендуется использовать легковесные скрипты JavaScript, оптимизировать время загрузки страницы, а также предоставить альтернативное содержимое для случаев, когда JavaScript не может быть выполнен или интерпретирован. Также можно использовать микроразметку JSON-LD для обозначения важной информации, которая может быть потеряна при индексации поисковыми роботами.

Как сделать сайт на JavaScript более дружелюбным для поискового робота

Сайты на JavaScript могут быть проблематичными для поисковых роботов «Яндекса» и других поисковых систем. Это связано с тем, что роботы, как правило, не выполняют JavaScript код, а только анализируют HTML-разметку. Однако, существует несколько способов, чтобы сделать ваш сайт более дружелюбным для поискового робота и улучшить его индексацию.

Первым шагом является использование правильной HTML-разметки. Старайтесь использовать семантические теги, такие как <header>, <nav>, <main>, <article> и другие. Эти теги помогут поисковому роботу лучше понять структуру вашего сайта и дать ему контекст для правильной индексации.

- Используйте атрибут alt для изображений. Поисковые роботы не могут анализировать изображения без текстового описания, поэтому использование атрибута alt поможет им понять содержание изображений.

- Избегайте «управления состоянием» страницы с помощью JavaScript. Например, не делайте содержимое страницы доступным только после выполнения каких-либо действий пользователя. Поисковый робот видит только исходный HTML-код и не сможет выполнить JavaScript действия.

- Используйте Server-Side Rendering (SSR) или Static Site Generation (SSG) для создания HTML-версии вашего сайта на стороне сервера. Это позволяет поисковым роботам видеть полную версию вашего сайта без выполнения JavaScript-кода.

Важно помнить, что поисковые роботы «Яндекса» и других поисковых систем постоянно развиваются и улучшают свои алгоритмы. Следовательно, хорошей практикой является регулярная проверка и анализ видимости вашего сайта в поисковых результатах, а также обновление и оптимизация его для лучшей индексации.

Использование техники prerendering для улучшения индексации

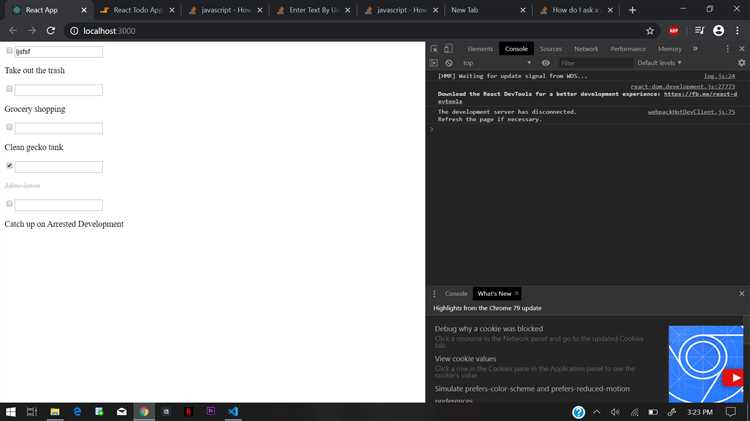

При создании сайтов на JavaScript, особенно с использованием современных фреймворков типа React или Angular, возникают проблемы с индексацией контента поисковыми роботами. Это связано с тем, что поисковые роботы не могут эффективно обрабатывать JavaScript-код и видят сайт в другом формате, чем пользователи. Однако, с использованием техники prerendering можно улучшить индексацию сайта и повысить его видимость в поисковых системах.

Техника prerendering предполагает предварительную отрисовку содержимого сайта на сервере, прежде чем пользователь получит его на экран. Таким образом, поисковый робот будет иметь доступ к полному и корректному HTML-коду сайта, что позволит более эффективно проиндексировать его контент. Это особенно важно для сайтов, где большая часть контента генерируется динамически с использованием JavaScript.

Преимущества использования техники prerendering:

- Улучшение индексации сайта поисковыми роботами

- Повышение видимости сайта в поисковых системах

- Увеличение охвата целевой аудитории

- Ускорение загрузки страницы для пользователей

- Улучшение пользовательского опыта на сайте

Для реализации техники prerendering существует несколько подходов. Один из основных – использование специализированных сервисов, которые предоставляют возможность предварительной отрисовки страницы перед отправкой ее на клиент. Примерами таких сервисов являются Prerender.io и BromBone. Также возможна самостоятельная разработка серверной логики, которая будет заниматься prerendering’ом страницы на стороне сервера и выдавать полностью обработанный контент поисковым роботам.

Проверка достаточности индексации

Для убедительности в том, что поисковый робот «Яндекса» успешно индексирует сайт на JavaScript, следует провести некоторые проверки. В данном разделе мы рассмотрим несколько методов и инструментов, которые помогут определить, достаточно ли страницы проиндексированы поисковым роботом.

Использование инструментов Яндекс.Вебмастер

Одним из наиболее удобных способов проверить индексацию страницы является использование инструментов Яндекс.Вебмастер. В этой панели управления можно проанализировать, какие страницы сайта были проиндексированы и какие нет. Также можно узнать, какие проблемы могут возникнуть при индексации и как их решить.

После регистрации и добавления сайта в Яндекс.Вебмастер, вам необходимо пройти в раздел «Индексация» и выбрать «Проверить индексирование». Затем можно ввести адрес страницы, которую вы хотите проверить, и увидеть результаты индексации.

Проверка в поисковой выдаче

Еще одним способом проверить индексацию страницы на JavaScript является использование самого поисковика. Просто введите адрес страницы в поисковую строку и посмотрите, есть ли она в выдаче. Если страница отображается в результатах поиска, это означает, что она была проиндексирована.

Однако, стоит учитывать, что индексация может занимать некоторое время, поэтому если страница была добавлена недавно или находится во временной индексации, она может не появиться сразу в выдаче.

Итог

Проверка достаточности индексации является важным шагом при оптимизации сайта на JavaScript для поисковых систем. Используя инструменты Яндекс.Вебмастер и проверку в поисковой выдаче, можно убедиться, что страницы успешно проиндексированы. Регулярная проверка индексации позволит своевременно обнаружить и исправить возможные проблемы с индексацией, что положительно скажется на видимости сайта в поисковой выдаче.